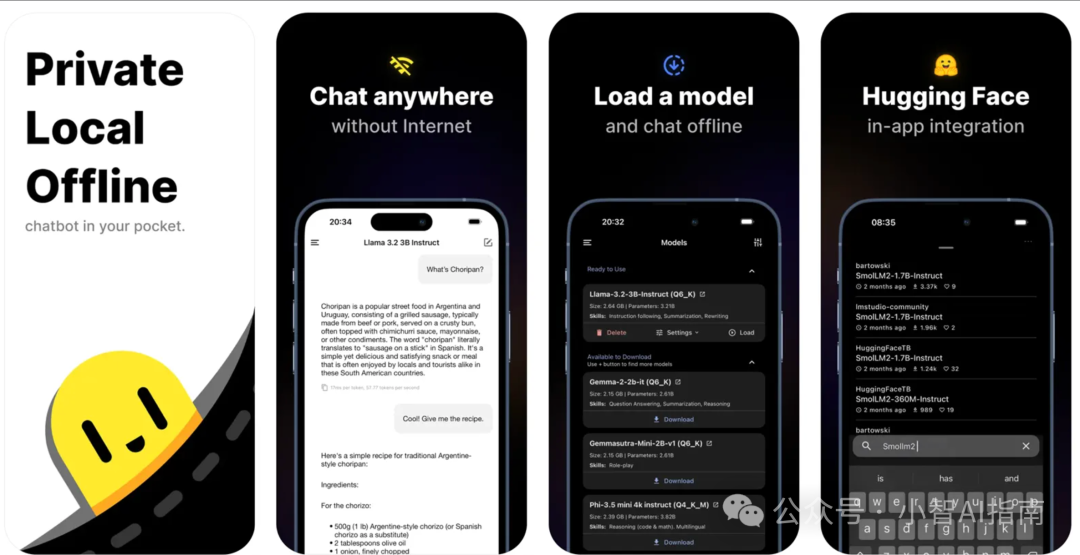

AI大模型不仅能在电脑端运行,现在手机端也能轻松实现本地部署!今天以GitHub开源项目PocketPal为例,教大家用手机直接调用大模型进行对话,全程无需联网操作。

部署步骤全解析

在手机浏览器打开PocketPal的GitHub页面,下载对应系统的安装包(安卓选.apk,苹果选.ipa)

像装普通APP一样完成安装,首次启动时会自动检测手机性能并优化配置

选择内置的轻量化模型(如1.8GB的MiniChat-7B),点击加载即可开始使用

核心亮点

完全离线运行:所有对话数据存储在手机本地

支持主流模型:兼容LLaMA、DeepSeek等架构的量化版本

开源可定制:开发者可通过GitHub源码自行调整交互界面和功能模块

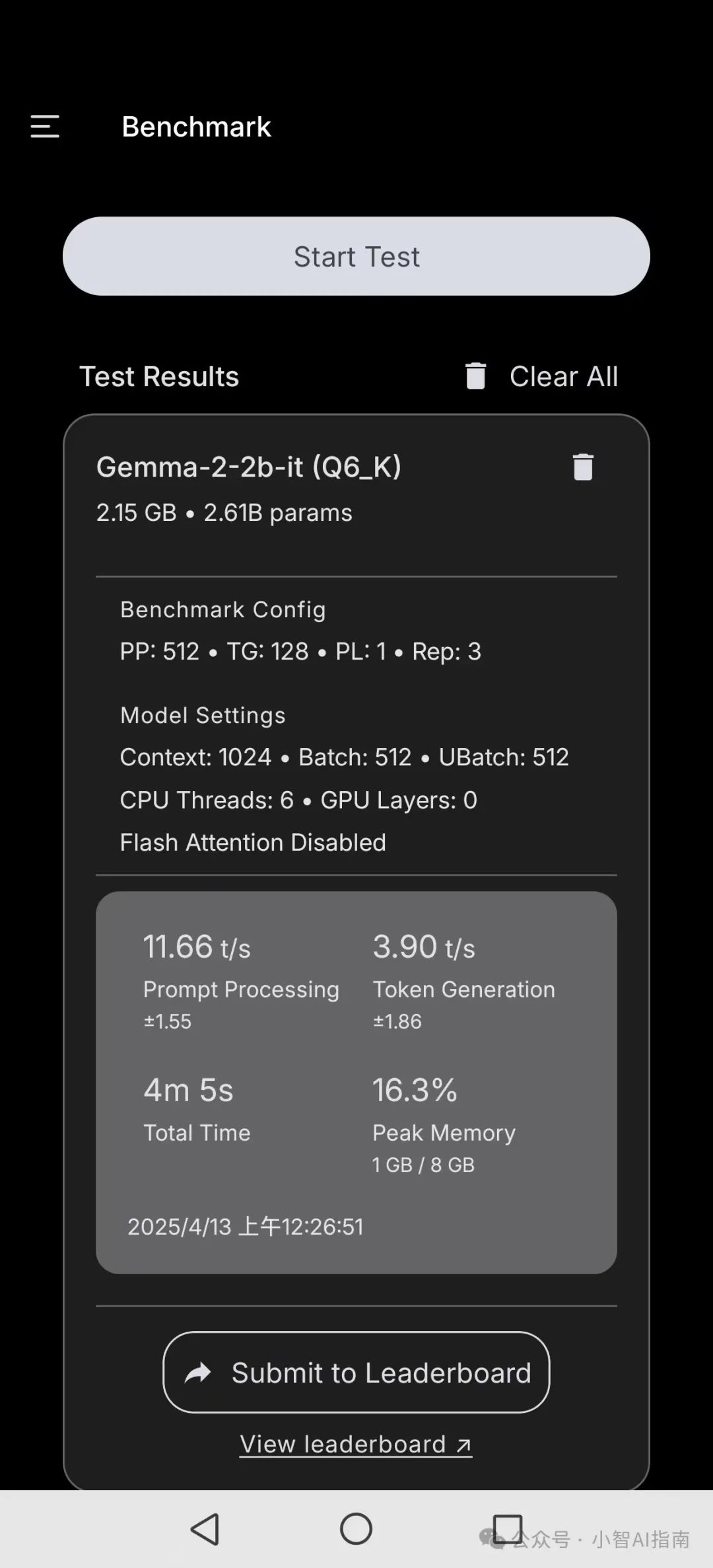

实测在2023款旗舰机型上,问答响应速度与网页版ChatGPT基本持平。项目已开放全部代码和模型适配方案,感兴趣可访问:github

由于我使用的是安卓手机,这里就跟大家演示一下安卓手机的操作过程。文章结尾附IOS版本下载链接。

Google Store应用商店下载

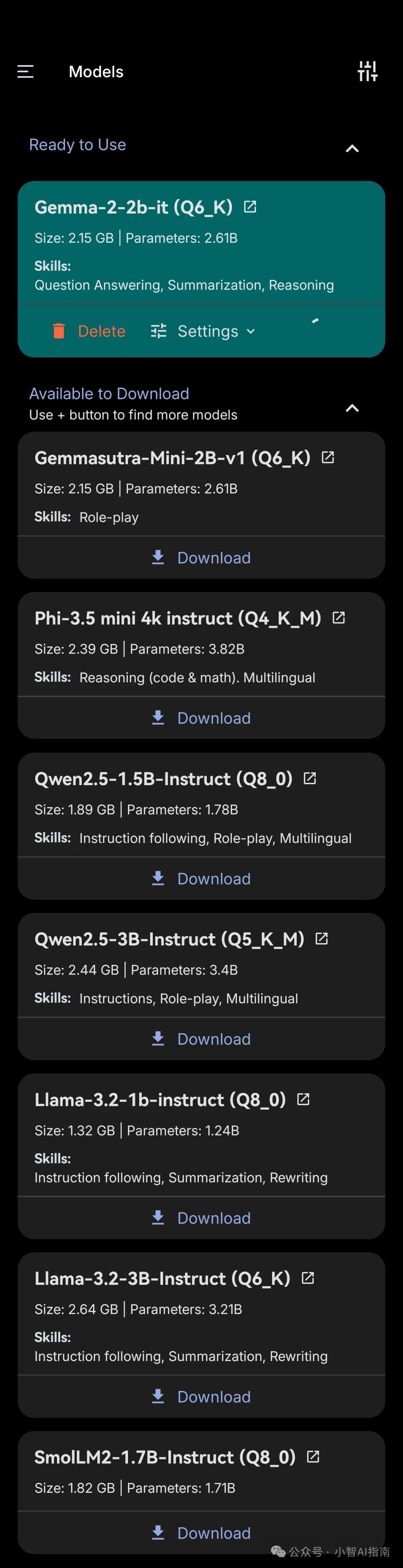

选择Gemma模型下载

验明身份

主要功能

• 离线AI辅助:无需联网,语言模型直接在设备上运行 • 模型灵活:支持下载并切换多个 SLM,如 DeepSeek R1、Danube 2 和 3、Phi、Gemma 2、Qwen 等 • 自动卸载/加载:应用后台运行时,通过卸载模型自动管理内存 • 推理设置:可自定义模型参数,包括系统提示、温度、BOS 令牌和聊天模板 • 实时性能指标:生成 AI 响应时,可查看每秒令牌数及每个令牌的毫秒数

Hugging Face集成

PocketPal AI 最新版现已与 Hugging Face 模型集成!在应用内可以直接从 Hugging Face Hub 浏览、下载和运行模型。大家可以根据自己手机的配置大小来选择适合自己的AI模型

还没有评论,来说两句吧...